Dans le domaine de l’informatique, il est essentiel de comprendre les différentes unités de mesure utilisées pour quantifier la capacité, la vitesse et la taille des données. Ces unités de mesure sont fondamentales pour comprendre les spécifications techniques des dispositifs de stockage, des réseaux et des performances des systèmes informatiques. Découvrons ensemble les principales unités de mesure en informatique et leur signification.

1- Les bits et les octets

En informatique, l’information est représentée et manipulée sous forme de bits et d’octets. Comprendre ces deux unités de mesure fondamentales est essentiel pour saisir les bases de la quantification des données et de la transmission d’informations.

Les bits

Un bit, abréviation de “binary digit” (chiffre binaire), est l’unité de base de l’information en informatique. Il représente la plus petite unité de stockage de données et peut avoir deux valeurs distinctes: 0 ou 1. Les bits sont souvent comparés à des interrupteurs électroniques qui peuvent être allumés (représenté par 1) ou éteints (représenté par 0). Par conséquent, les bits forment la base de la numérotation binaire utilisée par les ordinateurs pour traiter les données.

Les octets

Un octet est une unité de mesure couramment utilisée pour quantifier la taille des données. Il est composé de 8 bits. Étant donné que chaque bit peut prendre deux valeurs, un octet peut représenter 2^8 (soit 256) valeurs différentes. Les octets sont utilisés pour mesurer la taille des fichiers, de la mémoire et de la capacité de stockage des dispositifs informatiques.

L’utilisation des octets comme unité de mesure est basée sur la nature binaire des données informatiques. Par exemple, un simple caractère alphabétique peut être représenté par un octet. Cependant, les caractères non alphabétiques, tels que les symboles ou les caractères accentués, peuvent nécessiter plus d’un octet pour être représentés. Les octets permettent également d’exprimer des nombres entiers allant de 0 à 255 (soit 2^8 – 1) et sont utilisés dans la représentation des couleurs, où chaque composante de couleur est généralement exprimée par un octet (par exemple, le code RGB).

2- Les unités de mesure de la capacité de stockage

Le stockage des données revêt une importance capitale en informatique. Pour quantifier la capacité de stockage, diverses unités de mesure en informatique sont utilisées. Voici les principales unités utilisées pour mesurer la capacité de stockage des dispositifs informatiques :

Le kilo-octet (Ko)

Le kilo-octet représente 1024 octets. Bien qu’il soit couramment associé à 1000 octets en raison de l’utilisation des préfixes du système décimal, dans le contexte informatique, il est basé sur une puissance de 2. Le kilo-octet est souvent utilisé pour décrire de petites quantités de données, telles que des documents texte simples ou de petits fichiers.

Le méga-octet (Mo)

Le méga-octet est égal à 1024 kilo-octets. Cela signifie qu’un méga-octet équivaut à 1 048 576 octets. Les méga-octets sont utilisés pour mesurer des quantités de données plus importantes, telles que des fichiers multimédias, des images haute résolution ou de la musique.

Le giga-octet (Go)

Le giga-octet représente 1024 méga-octets, soit 1 073 741 824 octets. Les giga-octets sont couramment utilisés pour mesurer la capacité des disques durs, des clés USB et d’autres dispositifs de stockage de données. Ils sont également utilisés pour exprimer la taille des fichiers volumineux tels que des vidéos de haute qualité.

Le téra-octet (To)

Le téra-octet équivaut à 1024 giga-octets, soit environ 1 099 511 627 776 octets. Les téra-octets sont utilisés pour mesurer des quantités massives de données, notamment dans les centres de données, les serveurs et les systèmes de stockage à grande échelle.

Le péta-octet (Po)

Le péta-octet représente 1024 téra-octets, soit environ 1 125 899 906 842 624 octets. Les péta-octets sont utilisés pour quantifier des ensembles de données extrêmement volumineux, tels que les archives de recherche, les bases de données massives ou les infrastructures de stockage de données à grande échelle.

3- Les unités de mesure de la vitesse de transfert

Lorsque nous parlons de la vitesse de transfert dans le domaine de l’informatique, il est important de comprendre les différentes unités de mesure utilisées pour quantifier ce paramètre. La vitesse de transfert est généralement associée à la transmission de données entre des périphériques ou à la capacité d’un réseau à acheminer les données efficacement. Voici les principales unités de mesure utilisées :

Le kilo-octet par seconde (Ko/s)

Le kilo-octet par seconde représente la vitesse de transfert de 1024 octets par seconde. Il est généralement utilisé pour quantifier des transferts de données de petite ou moyenne taille. Par exemple, lors du téléchargement de fichiers sur Internet, la vitesse de téléchargement peut être indiquée en Ko/s.

Le méga-octet par seconde (Mo/s)

Le méga-octet par seconde équivaut à 1024 kilo-octets par seconde, soit environ 1 048 576 octets par seconde. Cette unité de mesure est couramment utilisée pour évaluer la vitesse de transfert de fichiers de plus grande taille, tels que des vidéos HD ou des fichiers de logiciels volumineux.

Le giga-octet par seconde (Go/s)

Le giga-octet par seconde représente 1024 méga-octets par seconde, soit environ 1 073 741 824 octets par seconde. Cette unité de mesure est utilisée pour quantifier des transferts de données à grande échelle, tels que les transferts de fichiers dans les environnements de stockage en réseau ou les débits de données des disques durs SSD performants.

Le téra-octet par seconde (To/s)

Le téra-octet par seconde équivaut à 1024 giga-octets par seconde, soit environ 1 099 511 627 776 octets par seconde. Cette unité est utilisée pour mesurer des transferts de données de très grande ampleur, tels que les débits de données dans les systèmes de stockage de données massifs ou les connexions réseau ultrarapides.

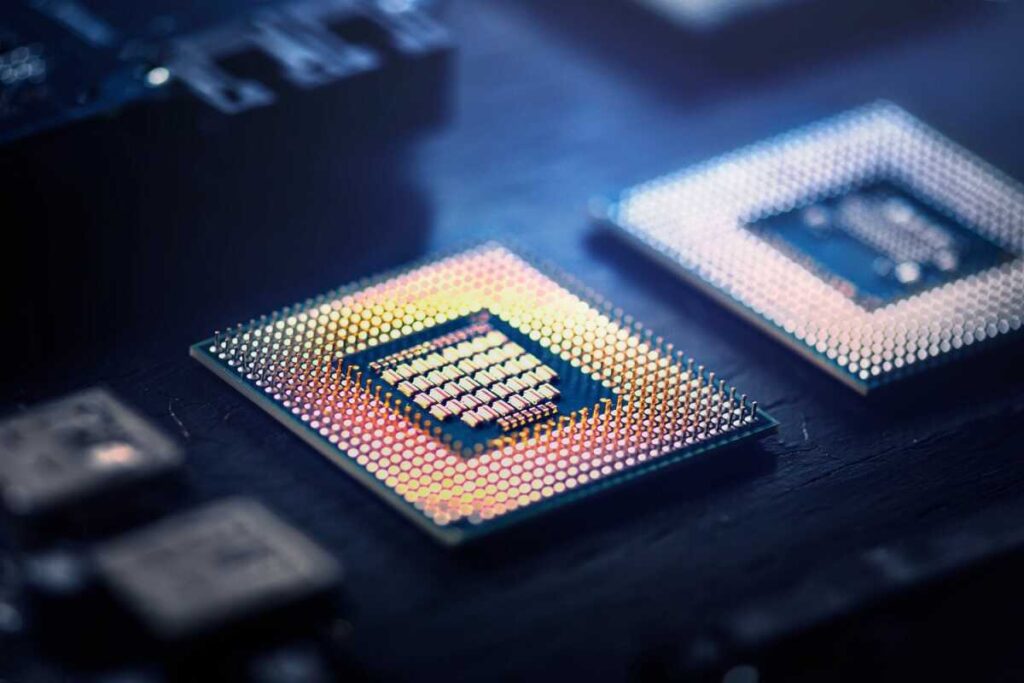

4- Les unités de mesure de la fréquence d’horloge

La fréquence d’horloge joue un rôle essentiel dans la mesure de la vitesse de traitement des informations par un processeur. La fréquence d’horloge est déterminée par le nombre de cycles d’horloge que le processeur peut exécuter en une seconde. Voici les principales unités de mesure utilisées pour quantifier la fréquence d’horloge :

Le kilohertz (kHz)

Le kilohertz représente 1000 cycles d’horloge par seconde. Les kilohertz sont généralement utilisés pour mesurer la fréquence d’horloge des dispositifs électroniques plus anciens ou de faible puissance. Ils sont moins courants dans les ordinateurs modernes, mais ils peuvent encore être utilisés dans certains contextes spécifiques.

Le mégahertz (MHz)

Le mégahertz équivaut à 1 million de cycles d’horloge par seconde. Les mégahertz étaient couramment utilisés pour mesurer la fréquence d’horloge des processeurs et des mémoires dans les ordinateurs plus anciens. De nos jours, bien que de nombreux processeurs fonctionnent à des fréquences supérieures au mégahertz, le terme mégahertz est encore utilisé pour désigner la fréquence d’horloge des processeurs grand public.

Le gigahertz (GHz)

Le gigahertz représente 1 milliard de cycles d’horloge par seconde. Les gigahertz sont couramment utilisés pour exprimer la fréquence d’horloge des processeurs modernes, notamment dans les ordinateurs personnels et les appareils mobiles. Une fréquence d’horloge plus élevée se traduit généralement par une capacité de traitement plus rapide du processeur.

La fréquence d’horloge est un indicateur important des performances d’un processeur, mais il convient de noter que la fréquence seule ne peut pas être utilisée comme unique mesure de comparaison entre les processeurs. D’autres facteurs tels que l’architecture du processeur, le nombre de cœurs et la présence de technologies d’amélioration des performances doivent également être pris en compte pour évaluer les performances globales d’un processeur.

5- Les unités de mesure de la bande passante réseau

La bande passante représente la quantité de données qui peuvent être transmises sur une période donnée. Voici les principales unités de mesure utilisées pour exprimer la bande passante réseau :

Le kilobit par seconde (Kbps)

Le kilobit par seconde correspond à 1000 bits transmis par seconde. Cette unité est généralement utilisée pour mesurer des vitesses de transfert de données relativement faibles, comme les connexions Internet à bas débit.

Le mégabit par seconde (Mbps)

Le mégabit par seconde représente 1 million de bits transmis par seconde. Les Mbps sont couramment utilisés pour mesurer les vitesses de transfert de données dans les connexions Internet à haut débit, les réseaux locaux (LAN) et les connexions sans fil.

Le gigabit par seconde (Gbps)

Le gigabit par seconde équivaut à 1 milliard de bits transmis par seconde. Les Gbps sont utilisés pour quantifier des débits de données élevés, notamment dans les connexions Internet à très haut débit, les réseaux locaux rapides (LAN) et les connexions fibre optique.

La compréhension des unités de mesure en informatique est essentielle pour évaluer et comparer les performances des dispositifs et des systèmes informatiques. Que ce soit pour mesurer la capacité de stockage, la vitesse de transfert, la fréquence d’horloge ou la bande passante réseau, ces unités fournissent des repères pour quantifier les données et les performances.